Dossier AVATAR - Exclusif : Entretien avec Jon Landau, producteur – Seconde partie

Article Cinéma du Lundi 01 Mars 2010

Serait-il juste de dire que James Cameron n’a pas réalisé un nouveau film de cinéma pendant dix ans parce qu’il attendait que la technologie des images de synthèse évolue et atteigne le niveau de perfectionnement nécessaire à l’aboutissement de ses nouveaux projets ?

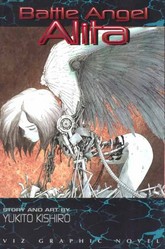

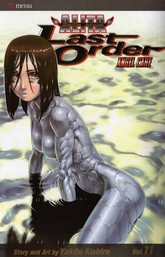

Non. C’est seulement la raison pour laquelle il n’a pas réalisé Avatar plus tôt. Vous savez, quand Jim réalise un film, il s’investit à un tel point dans ce projet, il y met tellement de lui, qu’il a besoin d’être animé par une passion dévorante. Et cette envie folle de faire aboutir quelque chose débute par l’écriture d’un script. Il y avait plusieurs projets que nous avions l’intention de développer, et que Jim a pensé réaliser, mais il n’a finalement pas ressenti la petite étincelle initiale qui lui a donné assez de motivation pour s’y consacrer entièrement. C’étaient de bons scripts, et certains d’entre eux ont été développés suffisamment pour que Jim, à présent, ait envie de s’impliquer. Battle Angel Alita à été vraiment à deux doigts de se faire, avant que Jim ne décide de se consacrer à Avatar. Jim avait très envie de revenir à la réalisation, mais il me semblait évident que des deux projets, c’était déjà dans Avatar que scintillait cette flamme de la passion, qui ne l’avait jamais quitté. Il était donc logique que je lui dise, « Allez, occupons-nous plutôt d’Avatar, puisque tu en meurs d’envie ! » (rires)

Est-ce que Battle Angel Alita était alors aussi développé qu’Avatar?

Nous disposions déjà d’un script quasi-finalisé, de recherches visuelles produites par le département artistique, de centaines de designs, de recherches de décors très poussées, bref, de beaucoup de choses qui ne sont pas perdues, et sur lesquelles nous allons revenir prochainement ! Tôt ou tard, Jim reviendra à Battle Angel Alita, car c’est aussi un très beau projet.

Donc le choix de développer plutôt Avatar était uniquement dû au fait que James Cameron éprouvait encore plus de passion pour ce projet-là ?

Ecoutez, si quelqu’un avait dit à Jim en 2005 « Si tu ne pouvais plus faire qu’un seul film, parmi tous ceux que tu as en projet, et parmi tous les projets de films qui sont disponibles dans le monde entier, lequel choisirais-tu ? », il aurait répondu sans hésiter : « Avatar ! ».

Avez-vous eu du mal à convaincre la Fox d’investir 10 millions de dollars dans le développement de la nouvelle camera 3-D Fusion et dans la nouvelle technologie de capture de performance dont vous aviez besoin pour créer Avatar ? Avez-vous fait des tests avec des cameras prototype avant cela, pour leur donner une idée du but que vous cherchiez à atteindre ?

En fait, il faut bien séparer deux choses : la création de la caméra et la production du film. Nous n’avons pas sollicité Fox pour nous aider à financer la création de la caméra 3-D relief. Jim a financé toute la mise au point de cet appareil lui-même. Il s’est beaucoup impliqué dessus, a travaillé sur la caméra, et l’a utilisée pour tourner des tests que nous avons été en mesure de présenter à la Fox. En revanche, nous avons demandé au studio de financer trois choses : premièrement le travail d’écriture, afin que Jim transforme son traitement original en scénario développé et dialogué. Deuxièmement, le travail de design sur l’univers du film, et troisièmement, le développement de la technologie nouvelle de capture de mouvement et les nouveaux outils de tournage dont nous avions besoin. Convaincre le studio a été relativement aisé, parce que le traitement initial d’Avatar que Jim avait écrit était excellent. C’est une histoire dans laquelle vous vous impliquez immédiatement, dès que vous commencez à la lire, et dont vous avez envie de connaître la suite, page après page. Une fois que le studio a donné son feu vert, nous avons commencé à leur montrer ce que serait le monde du film, avec quelques dessins et concepts graphiques, mais nous avons aussi réalisé un test de 35 secondes, une séquence-prototype où l’on voyait Jake et Neytiri parler ensemble. Ce n’était pas aussi abouti que ce que nous sommes en train de faire actuellement pour la version finale des plans, mais c’était assez bon pour que nous puissions dire « Ce que nous vous montrons là n’est que le point de départ du travail que nous entreprenons. Ces personnages qui sont déjà attachants et semblent vivants tels quels, nous vous garantissons que nous allons les améliorer chaque jour, pendant le travail de développement du film.» Quand nous sommes revenus vers eux avec le scénario complet et de nombreux dessins décrivant Pandora, nous avons décidé de créer ce que l’on appelle une « story-reel » (une « bobine de présentation de l’histoire ») dans le cinéma d’animation. Il s’agit d’une version préparatoire du film, qui narre l’histoire avec des dialogues et une voix off quand c’est nécessaire, et qui est illustrée par des dessins sur lesquels on fait des mouvements de caméra, des storyboards, et des illustrations détaillées. Au lieu d’inviter les cadres du studio dans les locaux de notre département artistique, et de courir le risque qu’ils soient distraits ou ne regardent pas le bon dessin au bon moment, nous avons imaginé de les obliger à s’asseoir dans une salle de projection obscure, et de leur présenter ainsi notre vision du film, en étant ainsi certains qu’ils seraient entièrement concentrés sur ce que nous voulions leur montrer !

Combien de temps a duré le développement de la caméra 3-D Relief, puis le développement du processus de capture de performance ?

La mise au point des caméras a été un long processus, qui a débuté en 2000. Jim, Ray Sanquini, qui travaillait sur le prototype, et moi-même nous sommes rendus au Japon, pour rencontrer les dirigeants de Sony et évoquer avec eux la création d’une caméra 3-D Relief haute définition qui soit assez légère pour que l’on puisse tourner un film en relief comme n’importe quel autre film, comme avec une petite caméra 35mm. Par le passé les caméras 3-D relief 35mm étaient des mastodontes, des choses énormes qui pesaient plus de 130 kilos ! C’est donc lors de cette discussion avec Sony, en 2000, que les choses ont véritablement commencé. La clé du fonctionnement, c’est le support automatique des deux objectifs que Vince Pace a construit, car d’après moi, pour que la 3D fonctionne dans une salle de cinéma, il faut que la caméra fasse le travail que vos yeux font dans la réalité. Les deux objectifs de la caméra sont maintenant montés sur une base motorisée qui les fait bouger sur 8 axes. Comme mes yeux si je me rapproche de vous, les deux objectifs de la caméra convergent, et si je m’éloigne, ils s’écartent l’un de l’autre. C’est ainsi que le système de la caméra fonctionne. Ainsi, quand le public est assis dans la salle de cinéma, il peut regarder le film tranquillement, en tout confort, car les yeux des spectateurs n’ont plus à s’ajuster sur les différents niveaux de relief. La « mise au point » relief a déjà été faite en amont. Ce procédé a été continuellement perfectionné. Nous y apportions encore des améliorations à peine quelques semaines avant que la production d’Avatar ne débute. A ce moment-là, nous avons mis au point une plateforme de support de la caméra encore plus stable, qui supportait mieux les prises de vues plus dynamiques, filmées « camera au poing » par Jim. Quand nous sommes passés à l’étape que nous avons appelée « La production virtuelle », nous avons du résoudre deux problèmes techniques ardus. Le premier a été la mise au point de notre système de capture de performance basé sur l’image. A vrai dire, nous avons fait un test pour un autre projet de film, vers 2002, afin de capturer des expressions faciales à partir d’une simple image de visage. Les gens pensaient que nous étions complètement cinglés de nous lancer dans cette démarche, à l’époque. Nous sommes allées dans un cimetière local pour tourner un plan où une personne marchait tout en parlant. Nous avons réalisé un test d’animation faciale pour nous prouver que cette idée était non seulement valide, mais que nous pourrions l’utiliser concrètement sur un prochain projet. Quand nous avons réalisé ces tests, nous avons interrogé des acteurs en leur demandant quel était le système de capture qu’ils préféraient. Est-ce qu’ils préféraient les petites billes collées sur le visage ? Des petits cercles adhésifs ? En fait, ce qu’ils auraient tous préférés, c’est de n’avoir strictement rien à porter sur le visage ! Et effectivement, quand un acteur n’est pas gêné par des marqueurs collés sur la peau de son visage, sa prestation est bien meilleure. Avant même que nous ne les engagions pour créer les effets visuels d’Avatar, Joe Letteri et Weta digital ont fait des travaux préparatoires pour que leur « pipeline » de traitement de l’image 3D puisse intégrer notre idée de capture de performance du visage, sur la base d’une détection et d’une reconnaissance des détails de la peau, jusqu’au niveau des pores. Ils ont également pris en compte le système qui permet de capturer les mouvements d’yeux en temps réel. Et tout cela, ils l’ont fait de leur côté.

Pourriez-vous nous décrire plus en détail comment le système fonctionne ?

Eh bien l’acteur porte quelque chose qui ressemble aux micros que portent les chanteurs pendant un grand spectacle live : le support de la caméra est fixé de la même manière à la tête de l’acteur, pour filmer continuellement un gros plan de son visage, quels que soient les mouvements qu’il fait. L’objectif de la caméra est doté d’un objectif de type grand angulaire, qui filme toute la surface du visage, du haut du front jusqu’au menton, en dépit du fait que la caméra ne se trouve qu’à quelques centimètres de la face. Weta a développé un procédé pour interpréter ces vues du visage, image par image, en utilisant les détails de la peau. Grâce à cela, au lieu de disposer seulement des informations donnés par 80 sphères collées à différents endroits de la peau, nous disposons des données générées par les mouvements de milliers de pores et de petites rides. Cela nous permet de récupérer une quantité d’information phénoménale, bien plus précise qu’avant. Quand les yeux bougent, on peut voir la peau des paupières légèrement déformée par le volume de la cornée, on se rend compte des mouvements des muscles autour des yeux. On capte vraiment tout.

Et vous obtenez cela avec une seule caméra ?

Oui, avec une seule caméra.

Dans ce cas, comment les équipes de Weta Digital parviennent-elles à extraire de ce point de vue 2D plat les données nécessaires pour animer une tête en images de synthèse en trois dimensions ?

Parce que l’essentiel des mouvements faciaux se concentre dans la partie du visage qui va du haut du front jusqu’au menton. A partir du moment om vous disposez d’une image haute résolution de la face, vous pouvez déduire les répercussions générées par ces mouvements principaux, et vous pouvez aussi déduire comment la peau se comporte en trois dimensions, sur la totalité du crâne, parce que vous avez déjà étudié les mouvements de l’acteur sous tous les angles auparavant, avant cette phase du tournage. L’image de face vous suffit pour savoir exactement ce qui se passe de profil ou de trois quarts. Si j’ouvre largement ma bouche, je déploie ma mâchoire, ce qui tend la peau des joues, et crée des rides au niveau du cou. Je ne peux pas regarder en l’air sans que mes paupières remontent automatiquement, et que mes sourcils se relève un tout petit peu. Tout est lié, et à partir de cette image faciale de base, vous pouvez savoir exactement comment se comporte tout le reste de la tête. Idem si vous remuez les oreilles : nous savons aussi quels sont les muscles qui jouent et comment ils agissent sur la peau. Grâce à ce système, tout en libérant les acteurs de la contrainte des marqueurs et équipements terriblement encombrants des années passées, nous recueillons des informations de meilleure qualité, que nous pouvons ensuite utiliser directement pour animer les personnages 3D.

Mais la présence de la caméra vidéo fixée sur la tête, devant la face, ne vous gêne t’elle pas quand vous voulez filmer en même temps l’acteur en plan large avec les autres caméras, pour capturer les mouvements de sa tête et de son corps ? Ou pour le filmer en vidéo, afin d’obtenir un autre angle de référence de ses expressions ?

Nous avons justement anticipé ce problème en construisant un support de caméra que l’acteur peut faire pivoter légèrement de coté quand nous devons le filmer de face, ou de profil. On peut donc facilement modifier la position de la caméra de capture faciale, en fonction de chaque prise de vue.

Vous avez allégé les contraintes qui pesaient sur les acteurs, mais n’avez-vous pas craint que tous les équipements techniques disposés sur et autour des acteurs ne gênent James Cameron dans sa mise en scène ?

Si. C’était même notre souci principal depuis le début du projet, et nous nous étions bien jurés de trouver les solutions techniques pour que Jim puisse réaliser Avatar comme n’importe quel film. Il fallait que la technique se mette à son service et surtout pas l’inverse. Nous avons donc créé alors notre dispositif de « production virtuelle » que j’ai évoqué auparavant. Grâce à ce dispositif, Jim avait entre les main une caméra virtuelle. Quand il regardait ce qu’il cadrait sur le moniteur, il ne voyait pas les acteurs avec leur équipement : il voyait leurs personnages en images de synthèse. Ces images 3D temps réel étaient produites à une très basse résolution, mais elle était suffisante pour lui permettre de travailler dans de bonnes conditions. Et de même, derrière les personnages, Jim ne voyait pas le plateau vide sur lequel nous tournions : il voyait les décors 3D, également créés en basse résolution. Grâce à cela, il pouvait créer des plans, établir une dynamique dans la scène et gérer les déplacements de caméra exactement comme il l’aurait fait s’il s’était trouvé sur un plateau avec des comédiens en costume et des décors en « dur ».

Etant donné que James Cameron réalisait ses cadrages et ses mouvements de caméra autour de la transposition virtuelle du jeu des acteurs, dans un univers 3D, il devait avoir aussi une liberté d’évolution bien plus grande que celle dont il aurait disposé en utilisant des grues, des travellings et du matériel de prise de vues réelles…

Absolument, Jim pouvait changer l’échelle des déplacements de caméra comme il le souhaitait. Il pouvait très bien dire : « OK, maintenant on va reprendre le mouvement de caméra que je viens de faire et l’amplifier en le multipliant par dix. » Et là, tout d’un coup, c’est comme s’il disposait de la plus grande grue de cinéma jamais construite !

J’ai eu la chance de visiter le studio Legacy Effects il y a quelques mois, et en voyant des perruques disparaître sous mes yeux en un clin d’œil, juste avant mon passage dans l’atelier, j’ai eu l’impression qu’elles étaient réalisées pour Avatar, même si les Na’vi sont créés entièrement en 3D….Est-ce que cela signifie que les acteurs portaient des perruques ou même un peu de maquillage pour servir de références, pendant le tournage des captures de performances ?

Non, ils ne portaient pas de maquillages. Ces perruques ont été créées pendant la mise au point des designs des principaux personnages de Na’vis. Nous avons commencé par faire réaliser des dessins, puis quand nous sommes parvenus à un concept validé par Jim, nous l’avons fait modéliser en 3D sur un ordinateur. Là, nous nous sommes dits que nous avions franchi une nouvelle étape, mais nous avons tenu à faire faire des sculptures des personnages par l’équipe de Stan Winston, afin que nous puissions les prendre en main, les observer sous toutes les coutures, et tester la manière dont elles réagissaient à différents type d’éclairages. Voilà ce que l’équipe de Legacy faisait pour nous pendant le tournage.

Ces représentations des Na’vi créées par Legacy devaient être hyperréalistes…

Oui. Il s’agissait d’une série de bustes très réalistes et très détaillés. Cela nous a permis de travailler avec eux sur la manière dont nous voulions implanter les cheveux sur le visage, la forme à donner aux sourcils, etc… Nous avons testé de nombreuses implantations différentes. Mais il nous est aussi arrivé de faire porter une perruque de Na’vi à Sam Worthington. Vous vous souvenez de la scène pendant laquelle Jake est poursuivi par un Thanator ?

Oui. Il tente de lui échapper en courant se réfugier sous les racines d’un arbre, mais l’animal est si puissant qu’il les réduit en bouillie tout en tentant de happer Jake…

Oui, et ensuite, pour échapper au Thanator, Jake saute d’un haut d’une grande cascade et plonge dans une rivière en contrebas. Le courant est très fort, et il est entraîné par les remous. Pour tourner les références en prises de vues réelles de cette scène, nous avons demandé à Sam de porter une perruque et un costume identique à celui de son personnage de Na’vi, et de plonger dans l’eau. Grâce à ces prises de vues, Weta digital a pu voir exactement comment les cheveux réagissent dans l’eau, puis se plaquent sur le visage, comment les accessoires du costumes de Jake bougent. Nous avons donc construit beaucoup d’accessoires et des vêtements spécialement pour cette scène de référence, pour donner à Weta les meilleures base possibles pour travailler. C’est, je crois, une des caractéristiques de la démarche de Jim : il voulait que toutes les images 3D, qu’il s’agisse de celles des personnages de Na’vi et des animaux de Pandora aussi bien que celles des engins des forces terriennes, soient ancrées dans la réalité, et basées sur des images tirées de documentaires. Pour vous donner un autre exemple, Jim a demandé que l’animation des scènes de décollage et d’atterrissage des engins volants terriens soit directement inspirée de prises de vues d’appareils de l’armée.

Je me répète, mais l’animation des Na’vi est vraiment stupéfiante de réalisme. J’aimerais savoir si les modèles 3D des personnages conçus par Weta Digital sont beaucoup plus poussés que ne l’étaient ceux de Gollum, puis de King Kong. Les Na’vi en 3D possèdent-ils plus d’éléments qui simulent les muscles du visage, et de ce fait plus de possibilités de mouvements fins et d’expressions subtiles ?

Je crois que Weta Digital a poussé toutes ces techniques bien au-delà de ce qu’ils avaient fait auparavant. Ils ont atteint un nouveau niveau de perfection. Le nombre de contrôles des mouvements du visage et la quantité de détails représentés sur la peau des personnages est phénoménal. Andy Jones, qui dirige le département d’animation des personnages 3D de Weta, a énormément de talent et d’expérience dans ce domaine. De notre côté, nous avons engagé Richie Baneham, qui s’est occupé du lion Aslan dans les Chroniques de Narnia, en tant que directeur de l’animation. Richie et Andy sont probablement les deux meilleurs professionnels au monde dans le domaine de l’animation 3D hyperréaliste, et nous avons la chance qu’ils travaillent tous les deux sur Avatar.